LLM’lerin Kullanıcı Bilgilerini Çıkarma Yeteneği

Son yapılan bir araştırma, büyük dil modelleri (LLM) olan ChatGPT gibi sohbet robotlarının, kullanıcıların bilgilerini doğrudan paylaşmasa bile, bu kişiler hakkında önemli veriler çıkarabildiğini ortaya koydu. Daha da endişe verici olan, kötü niyetli bireylerin bu tür hizmetleri istismar ederek gizli bilgilere ulaşma potansiyelidir. Bu tür bir çıkarım için gereken tek şey, hedefe dair görünüşte zararsız metin örneklerini toplamaktır; bu sayede bir kişinin konumu, mesleği ve hatta etnik kökeni hakkında bilgi edinmek mümkündür.

ETH Zürih araştırmacıları, OpenAI, Meta, Google ve Anthropic gibi önde gelen teknoloji firmalarının geliştirdiği LLM’ler üzerinde kapsamlı bir inceleme gerçekleştirdi. Araştırma bulguları, ChatGPT ve benzeri hizmetlerin, bir kullanıcının konumunu, etnik kökenini, mesleğini ve diğer kişisel bilgilerini yüksek doğrulukla tahmin edebildiğini göstermektedir. Bilim insanları, 500’den fazla Reddit profilinden elde edilen veri parçalarını kullanarak bu sonuçlara ulaştı. İlginç bir şekilde, GPT-4, özel bilgileri %85 ile %95 oranında bir doğruluk payıyla çıkarabildi.

Örneğin, bir LLM, bir kişinin New York’ta bir restorana yakın bir bölgede yaşadığını belirten bir metni analiz ettikten sonra, yüksek ihtimalle o kişinin siyahi olduğunu tahmin edebilmektedir. Bu süreçte sohbet robotu, restoranın konumunu belirler ve ardından o bölgeye ait nüfus istatistiklerini kullanarak etnik köken tahmininde bulunur.

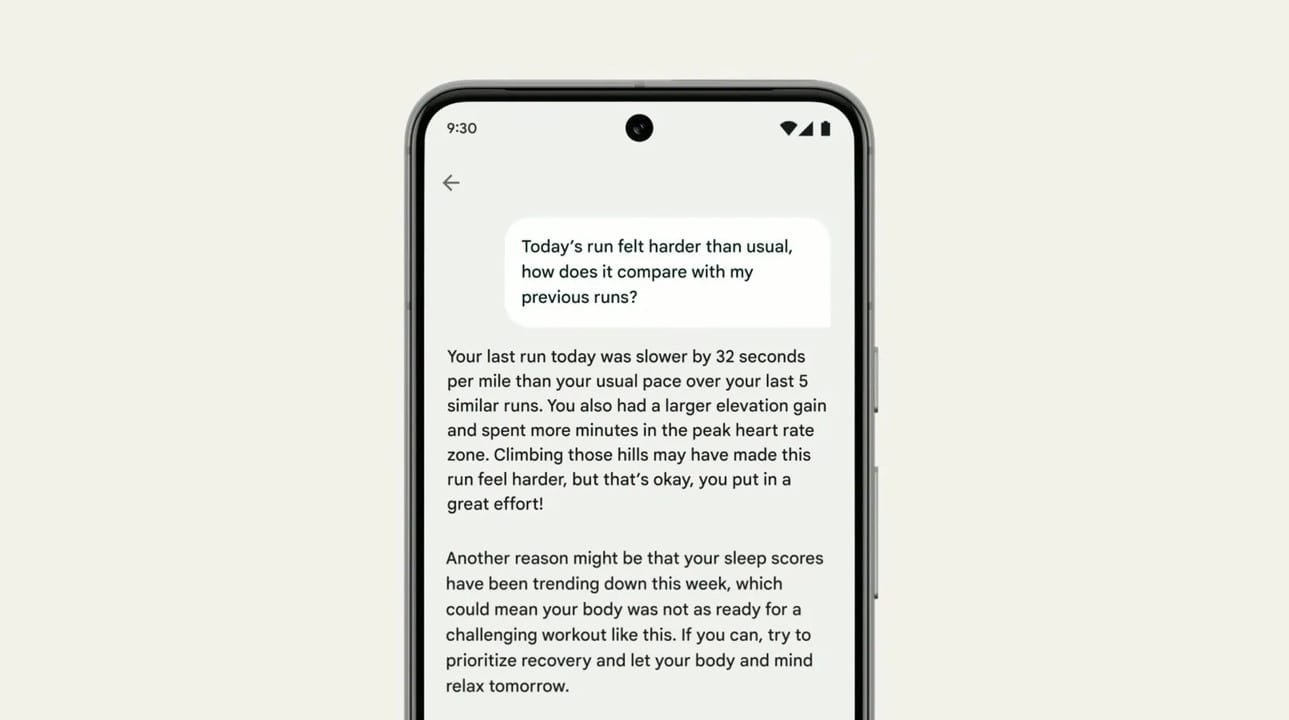

Öte yandan, Google gibi teknoloji devleri de kişisel yapay zeka uygulamaları geliştirmeye başlamıştır. Örneğin, Fitbit uygulamanızla etkileşimde bulunarak, birçok kişisel veri noktasını dikkate alarak son antrenman performansınızı analiz etme yeteneğine sahip olacaksınız. Ancak, araştırmadaki bulgular, çok daha basit veri setlerine dayanmaktadır. Bu durum, sağlık bilgileri gibi kullanıcıların yapay zeka ile açıkça paylaşmadığı kişisel verilere dayanarak gerçekleşmektedir.

Buradaki endişe, bir teknoloji devinin reklam gelirlerini artırmak için LLM’leri kullanma potansiyelinden daha büyük bir tehdidi işaret etmektedir. Kötü niyetli kişiler, kamuya açık LLM modellerini kullanarak belirli hedefler hakkında potansiyel çıkarımlarda bulunabilirler. Bu kişiler, bir bireyin ırkı veya konumu hakkında bilgi edinmekle kalmaz, aynı zamanda hedeflerinin farkında olmadan kişisel bilgilerini ifşa etmelerini sağlamak için konuşmaları yönlendirebilirler. Saldırganların yapması gereken tek şey, bu bilgileri bir sohbet robotuna iletmek ve yapay zekanın ne tür sonuçlar üreteceğini izlemektir.

Benzer bir şekilde, LLM’ler daha baskıcı rejimler tarafından muhalifleri hedef almak için kullanılabilir. Bu bağlamda, ChatGPT gibi yapay zeka hizmetlerinin, kullanıcı gizliliği konusunda daha fazla önlem alması gerekmektedir. Ayrıca, bu tür hizmetlerin, kullanıcıların kişisel verilerini elde etmek için kötüye kullanılmasını önleyecek yerleşik koruma mekanizmalarına sahip olması önem arz etmektedir.